D opo tutto questo tempo, possiamo dire che l’evoluzione dell’intelligenza artificiale non è andata come avevamo previsto? Abbiamo passato anni a evocare scenari alla Terminator in cui la ribellione delle macchine avrebbe costretto l’umanità alla schiavitù, abbiamo scritto articoli e libri sulla possibilità che i robot conquistassero una coscienza, e quindi magari anche i diritti civili, abbiamo immaginato tra il serio e il faceto se non potesse essere tutto sommato auspicabile avere come presidente una intelligenza artificiale. E poi ci ritroviamo ancora oggi, nel 2021, a litigare con Alexa perché non capisce come pronunciamo il titolo di una canzone? Eppure non c’è nulla di nuovo: le aspettative eccessive e le eccessive paure nei confronti dell’intelligenza artificiale sono da sempre parte della sua storia.

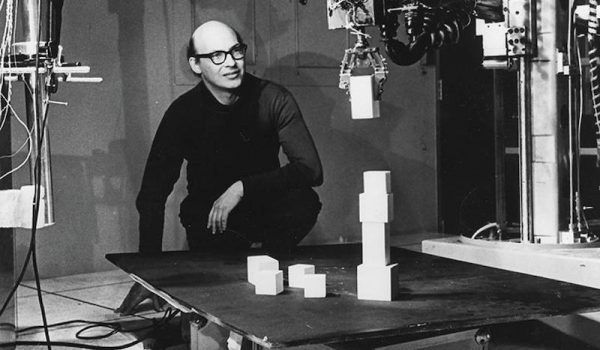

Nel 1956, una dozzina di scienziati si riunì al college di Dartmouth (New Hampshire, Stati Uniti) per lavorare a quello che pensavano essere un progetto non poi così ambizioso. Come scrissero nella presentazione, l’obiettivo era studiare “come ogni aspetto dell’apprendimento o qualunque altra caratteristica dell’intelligenza possa, in linea di principio, essere descritta in maniera talmente precisa da permettere di costruire una macchina in grado di simularla”. Una macchina, quindi, in grado di “usare il linguaggio, creare delle astrazioni e dei concetti, risolvere vari tipi di problemi riservati agli esseri umani e migliorarsi autonomamente”.

Per fare tutto ciò, calcolarono che sarebbe stato necessario lavorare tutti assieme per un paio di mesi – durante i quali venne anche coniato il termine stesso “intelligenza artificiale”. Non riuscirono nell’impresa, ma il loro fallimento non abbatté uno dei protagonisti di quell’evento: il matematico Marvin Minsky, che ancora negli anni Settanta aveva mantenuto inalterato il suo ottimismo. “Nell’arco di tre o otto anni, avremo una macchina dotata della stessa intelligenza generale dell’essere umano medio”, annunciò Minsky. “Una macchina in grado di leggere Shakespeare, lucidare un’automobile, occuparsi delle politiche aziendali, raccontare una barzelletta e litigare. A quel punto, la macchina inizierà ad addestrare se stessa a una velocità incredibile. Nel giro di pochi mesi raggiungerà il livello di genio e, pochi mesi dopo, i suoi poteri saranno incalcolabili”.

Le aspettative eccessive e le eccessive paure nei confronti dell’intelligenza artificiale sono da sempre parte della sua storia.

Dai pionieri di Dartmouth a oggi sono più di sessant’anni che si cerca di risolvere il mistero dell’intelligenza umana e di replicarlo per via informatica; spesso fallendo miseramente. E così ecco che anche le roboanti previsioni si sono via via attenuate. Ancora nel 2012, in una ricerca che aveva coinvolto 550 esperti del settore, il 10% degli scienziati informatici interpellati prevedeva l’arrivo di una intelligenza artificiale generale, ovvero in grado di competere con quella umana sotto ogni aspetto, entro il 2022. Il 50% scommetteva sul suo avvento entro il 2040. Oggi il 45% ritiene che avverrà prima del 2060, il 34% dopo il 2060 e un robusto 21% afferma che non succederà mai (va però detto che il campione di questo secondo sondaggio è limitato a 32 scienziati).

Dai due mesi previsti nell’entusiasmo iniziale, insomma, si è passato a decine e decine di anni (o forse mai), nonostante nel frattempo gli algoritmi basati sul deep learning – il sistema statistico che consente ai software di svolgere compiti specifici in maniera autonoma – abbiano rivoluzionato il mondo e nonostante la potenza di fuoco delle tecnologie digitali – in termini di potere computazionale e mole di dati a disposizione, i due elementi chiavi nell’addestramento degli algoritmi – sia incredibilmente superiore rispetto anche solo a un decennio fa.

Ma forse è proprio per questo che le nostre aspettative si sono placate: perché ormai l’intelligenza artificiale è diventata “normale”, parte integrante della nostra quotidianità. Pensate che effetto vi ha fatto vedere per la prima volta all’opera l’algoritmo di Facebook in grado di riconoscere il volto dei vostri amici nelle foto: sembrava magia (e come disse Arthur C. Clarke, “ogni tecnologia sufficientemente avanzata è indistinguibile dalla magia”). Oggi invece il riconoscimento facciale è un normale software basato sul deep learning che non solleva più fascinazione, ma semmai preoccupazioni. La stessa normalità si è ormai impossessata anche degli algoritmi di Spotify che individuano con incredibile precisione quale canzone potrebbe piacerci, delle applicazioni per smartphone che riconoscono le piante che inquadriamo, dei sistemi di traduzione automatica che grazie al deep learning hanno fatto enormi progressi e perfino degli algoritmi che valutano i nostri curriculum vitae e le nostre richieste di finanziamento.

Giochi di prestigio algoritmici

Una volta compreso il meccanismo – tutti questi sistemi analizzano centinaia di migliaia di dati (curriculum, immagini di piante o canzoni) per scovare correlazioni che consentono di fare previsioni spesso molto accurate – la sensazione di utilizzare uno strumento magico lascia strada alla comprensione di essere di fronte a uno strumento statistico molto sofisticato eppure forse quasi banale. Peggio ancora: le applicazioni del deep learning che recentemente erano riuscite a ricreare l’effetto “magia” si sono rivelate, a un’analisi più attenta, una sorta di gioco di prestigio tecnologico.

È il caso, celeberrimo, di Duplex, il bot di Google presentato nel 2018 e in grado di comunicare a voce con gli esseri umani senza che le persone dall’altra parte del telefono si rendessero nemmeno conto di avere a che fare con un’intelligenza artificiale. Duplex, in particolare, aveva suscitato clamore per la sua capacità di prenotare un appuntamento dal parrucchiere facendo uso anche di molti dei tic linguistici tipici di un essere umano, per esempio l’esitazione, stato d’animo che un computer non sperimenta mai.

Era l’alba dei computer senzienti? Saremmo stati ingannati dai bot come Joaquin Phoenix in Her? In verità, a un esame più attento, Duplex ha dimostrato tanto le potenzialità del deep learning quanto i suoi limiti. La ragione per cui è in grado di prenotare soltanto il ristorante o il parrucchiere è che è stato addestrato solo per questi specifici scopi, ascoltando centinaia di migliaia di conversazioni relative a questi ristrettissimi ambiti. Chiedete a Duplex cosa ne pensi dell’addio di Messi al Barcellona e otterrete le solite disorientate risposte a cui vi hanno abituato Siri o Google Assistant.

Peggio ancora: come ha affermato il neuroscienziato e fondatore di Robust.AI Gary Marcus, “Google Duplex è limitato ma non perché sta ancora compiendo i primi passi verso obiettivi ben più ambiziosi; la verità è che gli esperti di intelligenza artificiale non hanno nessuna idea di come riuscire a fare meglio di così. Le conversazioni non predefinite in cui si affrontano una vasta gamma di argomenti non sono ancora nemmeno all’orizzonte”.

Lo stesso vale per la tecnologia che più di ogni altra, circa un anno fa, ha messo in dubbio la nostra convinzione che le macchine non fossero (ancora) veramente intelligenti: il sistema progettato da OpenAI e noto come GPT-3. Specializzato nella riproduzione del linguaggio naturale, addestrato con 450 gigabytes di informazioni (tra cui l’intera Wikipedia in inglese), dotato di 175 miliardi di parametri (che nelle reti neurali – la struttura computazionale ispirata al cervello umano su cui agiscono gli algoritmi di deep learning – sono l’equivalente delle nostre sinapsi), GPT-3 ha sorpreso il mondo soprattutto quando il Guardian ha pubblicato un lungo, coerente e anche interessante saggio scritto da questo algoritmo e in cui affrontava proprio il tema del timore degli esseri umani nei confronti delle intelligenze artificiali.

“Perché, ti potresti chiedere, gli esseri umani dovrebbero mettersi di proposito in pericolo? Non è forse l’essere umano la creatura più avanzata del pianeta? Perché dovrebbero pensare che qualcosa di inferiore, in un senso puramente oggettivo, potrebbe distruggerli?”, si domandava nel saggio GPT-3, rispondendo alle sue domande attraverso citazioni di Matrix, analizzando le conseguenze della Rivoluzione Industriale, discutendo dell’etimologia di robot (“costretto a lavorare”) e molto altro ancora.

Difficile negare di essere di fronte a una forma di intelligenza quando un algoritmo è in grado di creare materiale originale di questo tipo. Anche in questo caso, però, e nonostante gli innegabili e impressionanti progressi, ci si è trovati ancora una volta di fronte a una sorta di gioco di prestigio. GPT-3 ha imparato a imitare il linguaggio umano eseguendo a ripetizione un semplice esercizio: completare la parte mancante dei testi forniti dai programmatori scegliendo tra una gamma di possibili soluzioni. Ogni volta che terminava una frase in maniera coerente, pescando le soluzioni dal dataset a sua disposizione, le connessioni neurali che avevano portato a quella soluzione venivano rafforzate. Dopo aver eseguito questo esercizio centinaia di migliaia di volte, GPT-3 ha imparato, per esempio, che completare la frase “apro l’ombrello” con “perché piove” ha più senso che con “dopo che il cane è uscito”. Non solo: GPT-3 è in grado di proseguire in questo gioco potenzialmente all’infinito: basta dargli una frase e lui può continuare a scrivere senza limiti, completando a oltranza le sue stesse frasi. Come ha spiegato sempre Gary Marcus, i sistemi come GPT-3 “non apprendono ciò che avviene nel mondo, ma imparano come le persone usano le parole in relazione ad altre parole”.

Quando vengono impiegati nel mondo reale, gli algoritmi di deep learning si scontrano ancora con un livello di complessità per loro troppo elevato.

Per passare da questi semplici esercizi a un saggio complesso come quello pubblicato dal Guardian ci vuole comunque qualche accortezza. Molto probabilmente, in vista del grande evento, GPT-3 ha ricevuto un addestramento specifico sul tema “robot ed esseri umani” (di materiale pubblicato ce n’è in quantità); dopodiché, come ammesso dal quotidiano inglese, un redattore umano si è occupato di mettere insieme i pezzi migliori delle decine di versioni che il software creato da OpenAI ha elaborato. Più che di vera intelligenza, si è di trattato insomma di un immenso taglia e cuci statistico.

In poche parole, né nel caso di Duplex né nel caso di GPT-3 possiamo parlare di un vero salto di qualità dell’intelligenza artificiale, ma semmai di un (comunque notevole) miglioramento delle performance e dell’accuratezza. Non siamo di fronte a un’evoluzione, ma a progressi incrementali in grado, nei casi più sofisticati e che richiedono enormi risorse, di imitare in maniera credibile l’intelligenza umana, ma solo a condizioni ben precise e in ambiti assai ristretti.

I limiti dell’intelligenza artificiale

Questi giochi di prestigio algoritmici (se così si può dire) non devono ingannarci e farci credere di essere di fronte a strumenti ancora più potenti di quanto già non siano. Lo dimostra anche un altro fatto: quando vengono impiegati nel mondo reale, gli algoritmi di deep learning si scontrano spesso con un livello di complessità tale da non essere proprio in grado di affrontarlo. “Nel caso dell’apprendimento rinforzato, una tecnica che ha permesso alle macchine di padroneggiare giochi come gli scacchi e il go, l’algoritmo utilizza estesamente il meccanismo dei tentativi e degli errori per discernere quali mosse lo porteranno alla vittoria”, si legge sulla MIT Tech Review. “Ma questo approccio non funziona negli ambienti caotici del mondo reale”.

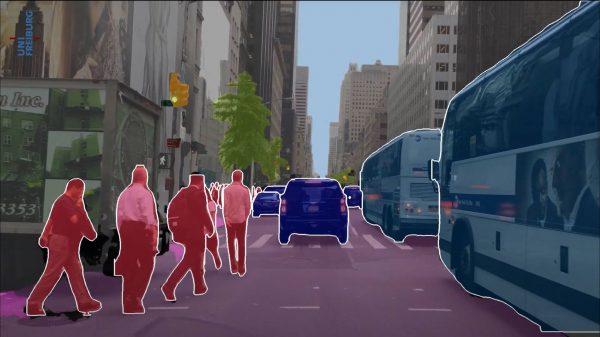

Qual è l’esempio più chiaro di un ambiente del mondo reale talmente caotico che anche le più potenti intelligenze artificiali non riescono a navigarlo? Una delle risposte è: il traffico cittadino. E infatti, in questo ambiente, le auto autonome che da anni sembrano essere sempre dietro l’angolo continuano ad avere problemi. Se n’è accorto anche Elon Musk, che dopo aver annunciato per anni che l’anno successivo sarebbe stato quello buono ha infine ammesso in un tweet che quello delle auto autonome è un “problema difficile”.

Perché è così complicato per un’auto autonoma governare in sicurezza il traffico cittadino di una metropoli caotica, mentre riesce abbastanza bene nel suo ruolo in ambienti più controllati (come può essere il parcheggio di un ospedale, le autostrade e alcune strade di città dai viali particolarmente ampi e ordinati)? La ragione è strettamente legata alle incognite e alle variabili che un algoritmo può trovarsi ad affrontare e che in un parcheggio sono assai ridotte, permettendogli di individuare – sempre per via statistica – quale sia il comportamento migliore da adottare.

Quando si tratta di guidare per la città, invece, è estremamente complicato individuare un pattern statistico che possa suggerire all’algoritmo quale sia la mossa giusta da compiere in una determinata situazione. Un conto è imparare a riconoscere i cartelli stradali e decifrare correttamente le indicazioni che essi riportano, tutto un altro paio di maniche è invece capire come destreggiarsi in città attraversate da pedoni che si comportano in maniera imprevedibile, da motorini che fanno lo slalom nel traffico, da biciclette in contromano, da tram, monopattini e automobili che fanno manovre improvvise e inaspettate.

Nel traffico cittadino, le incognite sono semplicemente troppe perché l’intelligenza artificiale possa ricondurle a un modello prevedibile. Una persona che sbuca all’improvviso dietro a un tram deciderà di lasciare passare l’auto che sopraggiunge o proverà ad attraversare? E il motorino che sembra sul punto di tagliarci la strada cambierà all’ultimo secondo idea o lo farà davvero? “La casualità dei comportamenti non può essere gestita dalla tecnologia di oggi”, per usare le parole del responsabile di Volvo per la guida autonoma Markus Rothoff.

Un grosso limite delle intelligenze artificiali è quindi quello di non essere in grado di gestire i più intricati scenari del mondo reale. Un secondo limite che caratterizza le AI odierne, come noto, è che oggi sono ancora del tipo narrow: intelligenze artificiali limitate, in grado di svolgere un solo compito per volta (per esempio riconoscere dei gatti) e che devono essere riaddestrate da capo per impararne un nuovo (fosse anche passare dal riconoscimento dei gatti a quello delle linci). La AI sarà anche in grado di battere il campione mondiale di un gioco incredibilmente complesso e astratto come il Go, ma quella stessa intelligenza artificiale, posta di fronte a un compito leggermente diverso, non sarebbe in grado di fare assolutamente nulla. È vera intelligenza?

“La specializzazione è per gli insetti”, scriveva l’autore di fantascienza Robert Heinlein nel 1973. Se è vero, le AI di oggi assomigliano più che altro a insetti in grado di superare anche l’essere umano in compiti specifici (come fanno anche le formiche, da un certo punto di vista), ma che falliscono miseramente quando si tratta di ampliare lo spettro delle abilità. “Tu ed io non dobbiamo cambiarci i cervelli, non è che ci mettiamo il cervello degli scacchi per giocare a scacchi e quello della dama per la dama”, per citare invece Shane Legg, co-fondatore di DeepMind (uno dei laboratori di ricerca più evoluti al mondo, di proprietà di Google).

Astrazione e buon senso

Eccolo, allora, il primo grande ostacolo da superare per dare vita a un’intelligenza artificiale meno simile a un turbo-insetto e più a un essere umano: dare a questi algoritmi la capacità di mettere assieme varie abilità senza che sia necessario ripartire da zero con l’addestramento ogni volta che si passa dall’una all’altra. Ma come si arriva fino a qui? Lasciando da parte gli scenari fantascientifici, quali strade stanno testando gli ingegneri informatici che – a DeepMind, OpenAI, in università come Stanford o all’MIT di Boston, e senza dimenticare il ruolo sempre più importante della Cina – lavorano veramente con l’obiettivo di creare, un giorno, una AI in grado di competere con l’elasticità del cervello umano?

Se oggi le intelligenze artificiali hanno un enorme vantaggio quantitativo sull’essere umano, ovvero la capacità di elaborare una mole di dati per noi neanche lontanamente gestibile, noi possediamo invece un vantaggio qualitativo che spesso viene riassunto tramite tre capacità tipiche dell’essere umano, tra loro parzialmente sovrapponibili: generalizzazione, astrazione, buon senso. È fornendo agli algoritmi una di queste qualità che gli ingegneri informatici sperano di conquistare la loro pietra filosofale del 21° secolo: l’intelligenza artificiale generale (in inglese “artificial general intelligence”, AGI). Una AI capace di pensare come un essere umano.

Fornendo “generalizzazione, astrazione e buon senso” agli algoritmi, gli ingegneri informatici sperano di ottenere finalmente una intelligenza artificiale generale.

Non è però facile nemmeno definire cosa siano alcune di queste qualità: cos’è l’intuito? Cos’è il buon senso? E soprattutto: come si traducono in termini informatici? Partiamo da quella che, oggi, sembra essere l’impresa più a portata di mano: dotare le AI della generalizzazione, ovvero – nell’interpretazione più semplice – della capacità di passare da un compito all’altro senza essere soggette a quello che viene chiamato “catastrophic forgetting”, la necessità di sovrascrivere tutto ciò che è stato imparato prima di passare a un compito differente.

La più semplice forma di AGI sarebbe quindi una sorta di coltellino svizzero digitale: un unico algoritmo in grado di svolgere molteplici compiti. In questo caso non ci sarebbe alcun passo avanti dal punto di vista dell’intelligenza. Sarebbe più una AI “di uso generale” che una AI particolarmente intelligente. Eppure, già arrivare fino a qui sarebbe una grande conquista. Chelsea Finn dell’Università di Berkeley e i suoi colleghi mirano a eliminare il problema del catastrophic forgetting attraverso un modello da loro chiamato MAML (model agnostic meta-learning), in cui un modello viene addestrato usando due algoritmi di machine learning, uno annidato dentro l’altro.

Come spiega ancora la MIT Tech Review, funziona più o meno così: “L’algoritmo interno viene addestrato come al solito tramite i dati e poi messo alla prova. In seguito, però, il modello esterno analizza la performance del modello interno – per esempio, l’accuratezza con cui riconosce alcune immagini – e la utilizza per imparare come aggiustare l’algoritmo di apprendimento di quel modello e migliorarne così le prestazioni. È un po’ come se un ispettore scolastico controllasse una manciata di insegnanti che utilizzano differenti tecniche di insegnamento e verificasse quale aiuti gli studenti a ottenere i punteggi migliori. Attraverso questo approccio, i ricercatori mirano a costruire una AI più robusta, più generalizzata, in grado di apprendere più rapidamente e con meno dati”.

La tecnica di Finn è stata estesa per progettare un algoritmo che impari usando solo una porzione dei “neuroni” presenti in una rete neurale artificiale, in modo che non si debba cancellare tutto ciò che ha imparato precedentemente, prosegue la Tech Review. “Un modello che usa meno neuroni avrà infatti a disposizione un certo numero di neuroni inutilizzati da dedicare a un nuovo compito nel momento in cui affronterà un nuovo addestramento, evitando così di andare incontro al catastrophic forgetting”.

È un primo passo verso l’obiettivo di una AI di uso generale. E che ci porta direttamente agli studi che guardano ancora più in là: alla possibilità di dotare le AI della capacità di astrazione. L’abilità di astrarre alcuni principi generali appresi portando a termine un compito e poi riapplicarli per eseguirne uno nuovo è una caratteristica cruciale del cervello umano, che ci consente – per fare un esempio banale – di riutilizzare le competenze necessarie ad andare in bicicletta anche per andare in motorino, senza dover imparare tutto da capo. Secondo Demis Hassabis, CEO di DeepMind, la chiave per arrivare fino a qui passa da una tecnica nota come transfer learning.

“Il transfer learning è un sistema di machine learning in cui un modello addestrato su un obiettivo viene riutilizzato per un secondo obiettivo collegato”, spiega Hackernoon. “L’idea alla base è che questa conoscenza precedente, conquistata grazie al primo compito, permetterà alla AI di ottenere una performance migliore, di essere addestrata più rapidamente e con meno dati rispetto a una rete neurale addestrata da zero sul secondo compito”. È qui che le cose si fanno interessanti: affinché questo metodo conduca alla AGI è necessario che il transfer learning possa essere applicato anche in ambiti distanti tra loro e che quindi richiedono una maggiore astrazione. Per ora, infatti, si sono ottenuti risultati significativi solo nel “trasferimento” di conoscenze tra loro strettamente collegate.

Né l’astrazione, né la generalizzazione sono però sufficienti a superare un altro storico limite delle intelligenze artificiali basate su deep learning: l’incapacità di distinguere tra correlazione e causalità. Per esempio, un algoritmo è assolutamente in grado di capire che la presenza delle nuvole nel cielo sia correlato alla pioggia, ma non ha idea del fatto che siano le prime a essere responsabili della seconda. Per un’intelligenza artificiale, il rapporto tra nuvole e pioggia è lo stesso che c’è tra l’uscita dei film di Nicholas Cage e le persone morte affogate in piscina che dati alla mano sembra esistere ma che, a meno di clamorose sorprese, rappresenta una classica correlazione spuria.

“Comprendere la causa e l’effetto è un grosso aspetto di ciò che chiamiamo ‘buon senso’ ed è un’area in cui, oggi, i sistemi di intelligenza artificiale sono totalmente incapaci”, ha spiegato Elias Bareinboim, direttore del laboratorio di Causal Artificial Intelligence della Columbia University. Un timore diffuso nella comunità che si occupa di deep learning è che non sarà mai possibile fare veri progressi in direzione dell’intelligenza artificiale generale finché questi algoritmi non saranno in grado di comprendere il rapporto tra causa ed effetto, oltrepassando così la loro esclusiva capacità di scovare correlazioni in una miriade di dati.

Sempre secondo Bareinboim, fornire alle macchine un po’ di buon senso, facendo comprendere loro il concetto di causa ed effetto, è l’unica strada per conquistare un domani l’auspicata intelligenza artificiale di livello umano. Non solo: la comprensione della causalità si sposerebbe alla perfezione con la necessità di astrarre la conoscenza: “Se le macchine potessero capire che alcune cose conducono ad altre, non dovrebbero ricominciare da capo ogni volta che devono imparare qualcosa di nuovo, ma potrebbero sfruttare ciò che hanno imparato in un campo e applicarlo in un altro”.

Tra gli scienziati che stanno lavorando per portare a termine questa impresa c’è Yoshua Bengio, informatico dell’Università di Montreal e vincitore del Turing Award 2018 assieme a Yann LeCun e Geoff Hinton. L’obiettivo di Bengio è fornire alle macchine ciò che chiama “meta-apprendimento”. Semplificando al massimo, invece di imparare a distinguere le persone che ballano da quelle che corrono mostrando all’algoritmo centinaia di migliaia di immagini di persone che eseguono le due diverse attività (lo stesso modo in cui impara a distinguere un gatto da un cane), la macchina potrebbe apprendere che alcuni movimenti delle gambe causano la danza o la corsa, e poi applicare questo concetto per comprendere che è sempre grazie alle gambe che le persone saltano, camminano o calciano un pallone. Sarebbe un primo passo verso la comprensione del rapporto di causa ed effetto e anche verso una generalizzazione della conoscenza.

Le potenzialità del deep learning

Tutti gli approcci trattati finora hanno soprattutto una cosa in comune: sono basati sulla tecnologia del deep learning. È davvero possibile ottenere intuito, buon senso e altre caratteristiche umane impiegando un metodo che comunque, alla sua base, è pura statistica? Secondo alcuni critici, tra cui il già citato Gary Marcus, la risposta è negativa. Un recente studio di DeepMind mira però proprio a mostrare come il deep learning – e in particolare il reinforcement learning, in cui l’algoritmo riceve un “premio” quando fornisce la risposta corretta a un problema che gli viene sottoposto (per esempio, riconoscere un gatto) – possa essere sufficiente a raggiungere la AGI.

“La ricompensa è sufficiente” è appunto il titolo di un paper sottoposto all’Artificial Intelligence Journal: “Nel nostro articolo ipotizziamo che l’intelligenza e le sue abilità associate possano essere considerate dei risultati della massimizzazione della ricompensa. Di conseguenza, la ricompensa è sufficiente per dare vita a comportamenti che esibiscono abilità studiate nell’intelligenza naturale e artificiale, compresa la conoscenza, l’apprendimento, la percezione, l’intelligenza sociale, il linguaggio, la generalizzazione e l’imitazione”.

Un robot intelligente dotato dei cinque sensi, del linguaggio e di mettere in relazione ciò che vede con ciò che tocca e così via, potrebbe quindi diventare intelligente come un essere umano?

Un esempio per capire meglio l’idea alla base delle affermazioni di DeepMind ha come protagonista uno scoiattolo il cui obiettivo è “minimizzare la fame”. Da una parte, le sue abilità motorie e sensoriali lo aiutano a individuare e raccogliere le nocciole quando il cibo è disponibile. Ma uno scoiattolo in grado soltanto di trovare il cibo è destinato a morire di fame quando questo diventa scarso. Ed è per questo che lo scoiattolo possiede anche la capacità di pianificazione e la memoria necessaria a nascondere le nocciole e a recuperarle in inverno. In più, lo scoiattolo possiede le abilità sociali e la conoscenza necessaria ad assicurarsi che altri animali non gliele rubino. La ricompensa di cui lo scoiattolo va in cerca è quella che motiva tutti gli animali (noi compresi): restare in vita. Gli stessi ricercatori di Deep Mind spiegano che, quando delle abilità associate con l’intelligenza emergono come soluzioni per ottenere la ricompensa, esse ci forniscono una comprensione più profonda, spiegandoci anche perché una tale abilità è emersa.

Ciò significa che un algoritmo a cui venga data una missione abbastanza a lungo termine e dotato di sufficiente potenza di calcolo potrebbe automaticamente, da solo, conquistare un’intelligenza artificiale generale? Non è così semplice, ovviamente, perché il modo più generale e scalabile per massimizzare la ricompensa è di progettare agenti che apprendono tramite l’interazione con l’ambiente. Secondo un’opinione diffusa, l’interazione con l’ambiente è infatti un elemento fondamentale. I bambini, per esempio, imparano a conoscere il mondo percependolo, facendo domande e associando le informazioni ottenute con ciò che vedono, con i suoni e con altre informazioni sensoriali; costruendosi così un modello sofisticato del mondo che permette, tra le altre cose, di navigare ambienti non familiari e di inserire ciò che hanno appreso, e le esperienze fatte, in un contesto più ampio (conquistando così intuito, buon senso e tutto il resto).

Un robot intelligente dotato dei cinque sensi, del linguaggio e di mettere in relazione ciò che vede con ciò che tocca e così via, potrebbe quindi diventare intelligente come un essere umano? Al momento, questa è una prospettiva ancora troppo distante. La già citata OpenAI ha però ricavato da GPT-3 un algoritmo “bimodale” che ha imparato a mettere in relazione il linguaggio e la vista (o meglio, la computer vision). Questo algoritmo ha infatti dimostrato di saper disegnare correttamente alcune immagini basandosi solo sulla loro descrizione testuale. Il sistema in questione è stato battezzato DALL-E (un gioco di parole tra Wall-E e Dalì) ed è stato addestrato sfruttando centinaia di migliaia di coppie testo-immagine pescate su internet. A furia di associarle, DALL-E ha imparato a ricavare autonomamente delle immagini dai soli testi. Per esempio, chiedendo all’algoritmo di creare un’immagine in stile cartoon di un pinguino che indossa un cappello blu, dei guanti rossi, una maglietta verde e dei pantaloni gialli il risultato è quello che vedete qui sotto.

Ancor più impressionante è il fatto che DALL-E sia stato in grado di creare dal nulla anche immagini in cui difficilmente può essere incappato online, com’è il caso di queste sedie a forma di avocado. Per quanto alla base ci sia sempre e comunque un modello statistico, è difficile continuare ad affermare che un’intelligenza artificiale non abbia la più pallida idea di che cosa sta facendo, e non comprenda il significato delle parole, quando è in grado di tradurle con impressionante precisione in immagini.

Un’intelligenza aliena

Qual è, allora, la strada migliore per arrivare a un’intelligenza artificiale generale? Apprendere nuove abilità senza rinunciare alle precedenti? Comprendere il rapporto causa-effetto? Generalizzare la conoscenza? O forse un’unione, che semrba ancora lontana, di tutto ciò? E in ogni caso, ciò che potremo conquistare seguendo questo percorso sarà davvero considerabile intelligenza o solo una sua pallida imitazione? E se invece un’autentica intelligenza artificiale possedesse caratteristiche radicalmente differenti da quelle dell’intelligenza umana? Si dibatte da sempre se l’imitazione dell’intelligenza umana possa essere considerata vera intelligenza, allo stesso modo sarebbe però scorretto considerare la nostra intelligenza come l’unica forma possibile, tarpando le ali, per così dire, a possibili evoluzioni sconosciute dell’intelligenza artificiale. È quello che, da un certo punto di vista, è avvenuto a Jeff Clune, ingegnere informatico di OpenAI.

In un approfondimento della Tech Review si racconta come Clune, assieme ai suoi colleghi, abbia sviluppato il generative teaching network, un algoritmo che apprende da solo quali dati generare per ottenere i migliori risultati nell’addestramento di un secondo algoritmo. Clune ha utilizzato in un esperimento uno di questi network per adattare un dataset di numeri scritti a mano spesso impiegato per addestrare gli algoritmi di riconoscimento immagini. Ciò che è venuto fuori era molto differente dal dataset originale curato dagli esseri umani. Erano presenti centinaia di “non proprio cifre”, in cui, per esempio, era rappresentata solo la metà superiore del numero sette o ciò che sembrava essere la fusione di due cifre differenti. Alcuni di questi esempi erano assolutamente difficili da decifrare. Nonostante ciò, il set di dati generato dalla AI ha fatto un ottimo lavoro nell’addestrare il sistema di riconoscimento della scrittura e a identificare delle cifre vere e proprie.

Forse dovremmo solo cambiare prospettiva: già oggi osservare un’intelligenza artificiale all’opera è quasi come visitare culture aliene.

Altri esempi ci ricordano invece come i sistemi digitali di questo tipo vivano in un ambiente completamente differente dal nostro e seguano diverse logiche fisiche. Per esempio, un sistema di deep learning a cui era stato insegnato a giocare a nascondino ha imparato a sfruttare dei glitch del suo ambiente virtuale per passare attraverso i muri e sfruttare altri trucchetti. Allo stesso modo, gli algoritmi che si sono messi alla prova con gli scacchi o con il già citato go hanno compiuto mosse che ai nostri occhi sembravano errori – e che i giocatori umani anche più esperti non avrebbero mai compiuto – ma che si sono poi rivelate fondamentali nel portarli alla vittoria. Sono comportamenti di questo tipo che hanno portato a parlare di “intelligenze aliene”, un termine che ovviamente non tranquillizza chi teme che questi sistemi possano rivelarsi un rischio esistenziale per la specie umana.

L’idea che possa nascere un Signore dei Pupazzi dotato di coscienza e intelligenza elevatissima continua a restare pura e semplice fantascienza. Nonostante questo, ha spiegato Jane Wang di DeepMind, se le AI imparano ad addestrarsi da sole è inevitabile che riescano a individuare tecniche di apprendimento a cui le persone non avrebbero mai pensato: “L’indeterminatezza è, per definizione, qualcosa di inaspettato e la stessa idea di portare le AI a fare qualcosa che non avevamo previsto significa che questa sarà sempre più difficile da controllare”.

Per usare un paragone dello stesso Clune, osservare un’intelligenza artificiale all’opera “è quasi come essere in grado di visitare delle culture aliene. I viaggi interstellari sono incredibilmente difficili, ma potenzialmente abbiamo la possibilità di creare delle intelligenze aliene per via digitale”.